Раз добрались до этого шага, значит большое дело, а именно сама установка системы с той или иной степенью успешности был вами победно завешен. Закончив победные пляски с бубнами, пора пиступать к следующему этапу – настройке и подготовке к работе. Что я под этим подразумеваю? Тут имеется несколько моментов.

Ну во первых я установил бы последние обновления. Это всегда важно и делать надо всегда и на любой системе, не важно для чего она предназначена. Обновления помогают спасти от многих проблем знаете. На Nexenta, обновления ставятся практически также как на Debian, однако со своими особенностями характерными для фич zfs. Здесь, при большом обновлении, снимается снепшот системного диска, таким образом, чтобы при каких-либо проблемах откатится на предыдущее состояние системы. Очень и очень удобно знаете ли. Поначалу непривычно, но очень впечатляет, когда к этому привыкаешь и осваиваешь в нужном объеме. Делается это с помощью команды apt-clone, примерно таким образом:

#apt-clone upgrade

This operation will upgrade your system using ZFS capabilities. Proceed ? (y/n) y

Updating APT sources ...

Initiating Nexenta upgrade procedure. Please wait...

Не забываем, что надо в /etc/apt/source.lst прописать правильные репозитории, откуда будут качаться обновления, все как в Debian/ Далее будет производится скачивание, и установка нужных пакетов в зависимости от того какая версия nexenta у вас установлена и какие пакеты нужно обновлять. apt-clone работает по тому же принципу что и apt-get за исключением создания снепшота после обновления и ребута после этого самого обновления, если он требуется конечно. Вообще процедура довольно безопасная, но я ее все равно немного побаиваюсь, поскольку первый раз когда я это делал, я запорол систему и у меня не грузилось больше ни чего и ни с какого снепшота. Видимо я что-то делал не так, но поскольку ход моих действить восстановить не представлялось никакой возможности, то это осталось тайной покрытой густым мраком.

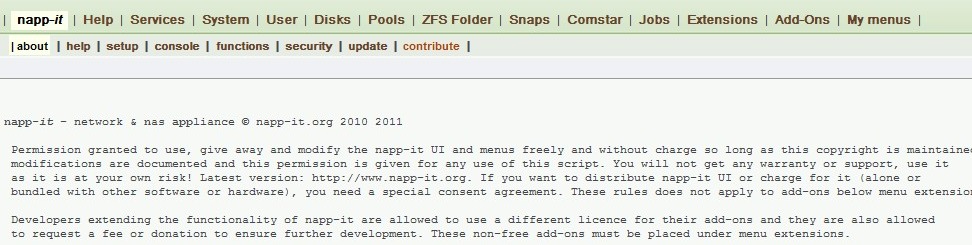

После установки обновлений, стоит проверить что все работает по прежнему хорошо. Проверили? Очень хорошо, я и не сомневался, что все по прежнему работает. Далее, я обычно ставлю такую полезную приблуду как napp-it. Это бесплатный веб-интерфейс для управления всеми основными фишками системы, приложениями и вообще практически всем, что есть в системе. Очень удобная штука, особенно по началу, когда только постигаешь возможности системы и опыта не хватает все делать через консоль.

Ну а если у вас NexentaStor, то там необходимости ставить веб-интерфейс нету, там он уже есть, встроен уже разработчиками, остается только через него проапгрейдить систему и поставить нужные плагины, которые вам потребуются по работе. Через napp-it можно делать очень широкий спектр действий с системой, пулами, папками, ну и вообще всем всем. Единственно что он имеет тот же недостато что и все веб-интерфейсы, если операция занимает слишком много времени, она отвалиться по таймауту и резльтатов ее выполнения вы никогда не увидите. Но для таких задач есть консоль, она поможет со всем разобраться.

Важный момент, который я обычно делаю до ввода сервера в основную работу – это настройка аггрегации на сетевых карточках. Сетевых карточек в материнских платах сейчас ставят не мало, зачем использовать только одну если можно использовать все как одну. Для этого, правда, необходимо чтобы ваш свич, куда будут воткнуты эти сетевушки умел поддерживать стандрат IEEE 802.1AX. Вещь это распространенная, во всех более или менее нормальных свичах она есть. Как настраивать свич я рассказывать не буду, там все зависит от производителя. Что касается Nexenta, то там это делается командой dladm. Допустим у вас есть 2 интерфейса на материнке, которые видны как e1000g0 и e1000g1 и вы хотите их аггрегировать по активному типу, тогда комманда которую надо вам будет ввести в консоле, будет выглядеть следующим образом:

dladm create-aggr -L active -l e1000g0 -l e1000g1 aggr1

После выполнения этой команды создасться аггрегирующий интерфейс aggr1, который будет состоять из двух физических интерфейсов e1000g0 и e1000g1. Осталось прописать адреса в стартовые конфиги системы. Для это в каталоге /etc/ создаем файлик hostname.aggr1, куда добавляем всего одну строчку:

xxx.xxx.xxx.xxx netmask 255.255.255.0 broadcast + up

Где xxx.xxx.xxx.xxx это IP адрес. Маску тоже указываем правильную. Шлюз прописывается в файлике /etc/defaultrouter. Вот в общем-то и все, если со свичем у вас тоже все получится, то никаких проблем с использованием подобного рода аггрегации на этой системе не будет, а польза будет. Согласитесь, что совсем не хочется упереться в производительность сети на уже во всю работающем сервере и судорожно искать как эту проблему решить.